Data Analytics

Data Analytics Lösungen von der Datenquelle bis zur Erkenntnis.

Data Analytics Lösungen sind die Grundlage für große Effizienz- und Qualitätssteigerungen in Prozessen, in der Entwicklung und bei Produkten.

Nutzen Sie unsere individuellen, agil entwickelten und skalierbaren Data Analytics Lösungen, um entscheidende Erkenntnisse für Ihre Produktentwicklung rund um Mobilität und Energie zu gewinnen. Bis 2025 wollen 75 % der Unternehmen ihre Data Analytics Projekte zur Serienreife bringen und wir unterstützen sie dabei.

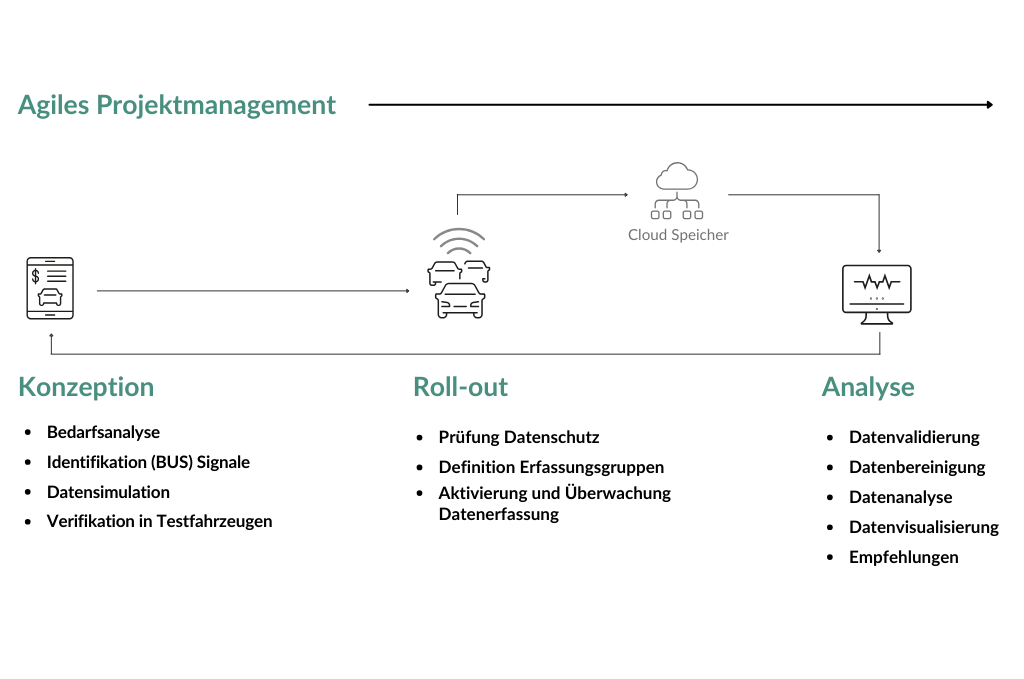

Gewinnen Sie Informationen aus Serienfahrzeugen. In Echtzeit.

Wir wandeln Ihre Fragestellungen in eine, im Hinblick auf Kosten optimierte Datenerhebungskampagne, führen diese effizient durch und analysieren die erfassten Daten mit modernster Data Science und Analytics.

So begleiten wir Sie vom ersten Interview bis hin zur Erstellung von individuellen Entscheidungsvorlagen in Form von Grafiken und Dashboards.

- Direkt einsetzbar, ohne eigene Data Science Ressourcen

- Langjähriges Big-Data Analytics Know-how

- Technisches Automotive Know-how

- Skalierbare und serienreife Lösungen

- Von der Frage zur datenbasierten Antwort mit minimalem Zeitaufwand

Agile Data Analytics - der schnelle Weg zum Ziel!

Die Umstellung auf Agile Data Analytics hat die Umsetzungsgeschwindigkeit in unseren Projekten mehr als verdoppelt. Bei weitem kein Einzelfall, aber nur, wenn man es richtig macht.

End-2-End oder Teillösungen? Sie legen fest, was für Ihr Unternehmen passt.

Wir helfen Ihnen dabei, Ihre Fragestellungen in eine optimierte und effiziente Datenerhebung umzuwandeln, die Daten zu bereinigen, auszuwerten und hilfreiche Datenvisualisierungen, Dashboards und Vorhersagen zu entwickeln. In Ihrer eigenen IT Umgebung oder in der von uns entwickelten Cloud.

40 GB Daten pro Tag haben wir für unsere Kund*innen im letzten Jahr in wegweisende Erkenntnisse umgewandelt - wie steht es mit Ihren Daten?

Neues rund um das Thema Data Analytics:

Erfolgsgeschichten

Datenanalyse / Datenanalyse Pipelines

Immense Datenmengen in der Automobilindustrie eröffnen immenses Potenzial. VISPIRON SYSTEMS entwickelt Datenanalyse Pipelines zur Produktoptimierung in der Entwicklung, zur Etablierung neuer digitaler Geschäftsmodelle und Aftersales Lösungen, sowie zu Reporting- und Nachweiszwecken.

Datenanalyse von Fahrmanöver-Messdaten

Die VISPIRON SYSTEMS entwickelt im Auftrag eines OEM ein Analyse-Tool zur automatisierten Auswertung von Fahrmanöver-Messdaten für Prototypenfahrzeuge. Diese Daten werden hinsichtlich signifikanter Kennwerte analysiert und grafisch aufbereitet.

Blog Data Analytics

Entschlüssle deine Daten

Wahrscheinlich hast du schon einmal die Wörter Data Science, Big Data, Datenanalyse und maschinelles Lernen gehört, und eventuell denkst du nun, dass es sich hier doch nur um Schlagworte handelt, die mit dir eigentlich gar nichts zu tun haben. Aber du solltest diesen Dingen eine Chance geben!

Agile – auch für Data Analytics Projekte

Die Umstellung auf Agile Data Analytics hat die Umsetzungsgeschwindigkeit in unseren Projekten mehr als verdoppelt. Bei weitem kein Einzelfall, aber nur, wenn man es richtig macht. Unser Blog Auto Dalibor erzählt dir, welche vier Faktoren unser Projekt zu wahrer Agilität verholfen haben.

Unsere Zertifikate

Unser Team arbeitet für Ihren Erfolg.

Dalibor Sevcik

Dalibor geht es vor allem darum zu entdecken, welche Bedeutung die Daten haben. Tools und Methoden sind nur Mittel zum Zweck und sollen dienen, nicht herrschen. Das gleiche gilt für agile Methoden vs. True Agilität.

Team Leader & Inhalt-Fokussierter

Nadia Poulou

Nadia ist eine vielseitige Expertin, deren Schwerpunkt auf der Visualisierung und Kommunikation von Datenerkenntnissen liegt. Dank ihrer langjährigen Erfahrung kann sie auf ein breites Spektrum an Tools und Methoden zurückgreifen, um Geschäftsziele optimal zu unterstützen.

BI Data Analystin & Schweizer Taschenmesser

Daria Zaika

Daria liebt es sich mit neuen Themen auseinanderzusetzen. Von den Netzwerken bis hin zu KI-Modellen – alles lernt sie gerne um ihr Skillset zu erweitern und neue Lösungen zu finden.

Data Analystin & Learn-Enthusiastin

Alejandro Torra Benach

Alejandro ist auf der ständigen Suche nach neuen Herausforderungen. Dabei ist er stets hilfsbereit und lebt nach dem Motto: Wenn es beim ersten Versuch nicht klappt, nenn es einfach Version 1.0.

Werkstudent & Lern-Enthusiast

Jamiu Mustapha

Jamius Fähigkeiten große Datensätze zu analysieren und zu interpretieren, kombiniert mit seinem technischen Fachwissen, ermöglicht es ihm, datenbasierte Entscheidungen zu treffen.

Data Analyst & Data Craftsman

Timo von Zitzewitz

Timo ist Experte in der automatisierten Messdatenumwandlung mit Schwerpunkt auf Batch Skripten und Phyton-Programmierung. Seine Fachkenntnisse und Leidenschaft für innovative Lösungen machen ihn zu einem wertvollen Beitragenden in der Entwicklung nachhaltiger Mobilität.

Data Analyst und Innovationstreiber

Tobias Schönmüller

Tobias liebt die Herausforderung, in große Datenmengen einzutauchen und durch fortschrittliche Analysetechniken Erkenntnisse herauszufischen.

Data Analyst & Erkenntnisforscher

Simon Schlereth

Simon ist ein erfahrener Data Analyst, der es liebt Erkenntnisse aus Daten zu gewinnen und damit Mehrwerte für die Kunden zu generieren. Er schätzt die Vielfältigkeit der Aufgaben und die umfangreichen Lernmöglichkeiten, die die Tätigkeit mit sich bringt.

Data Analyst & Filigranist

Elena Giacomazzi

Elena ist eine kreative Data Analystin, die sich für nachhaltige Lösungen engagiert. Mit ihrem breiten Fachwissen und ihrer Fähigkeit, komplexe Daten zu durchdringen, unterstützt sie Unternehmen dabei, datenbasierte Entscheidungen zu treffen.

Wir freuen uns auf Ihre Kontaktaufnahme.

Dalibor Sevcik

Teamleiter Data Analytics

Jetzt anrufen

+49 151 27657720